ある日、あなたの手元のスマホやPCに、70億パラメータの巨大なAIと肩を並べる”小さなAI”がいると知ったら、どう感じますか?

「そんな馬鹿な」と思うかもしれません。

でも、その”馬鹿な話”が現実になったのです。

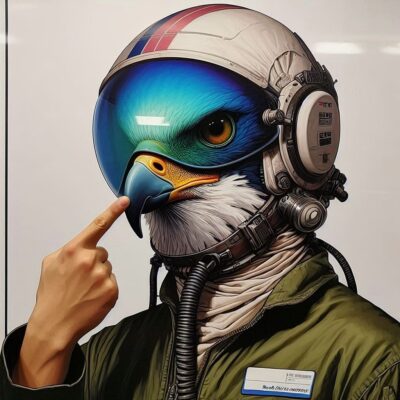

UAE 発の研究チームが発表した「Falcon-H1」は、AIの世界に新しい風を吹き込んでいます。

このブログでは、その魅力をやさしく、そして丁寧にひもといていきます。

Falcon-H1 とは? 小さな体に大きな力を宿したAI

Falcon-H1 は、従来のAIモデル(特にTransformer)では難しかった「長い文章の処理」や「低リソース環境での高速動作」といった課題を”ハイブリッド頭脳”で解決する新世代の言語モデルです。

ポイント①:Transformer × Mamba のハイブリッド設計

これまでのAIは、Transformer か、それに代わる新構造か、どちらか一方を採用してきました。

でも Falcon-H1 は違います。

「Transformer の注意力」と「Mamba の記憶力」、ふたつの頭脳を”並列に”搭載したのです。

Transformer は短期的な情報に強く、Mamba は長期記憶に優れます。

例えるなら、短距離走の選手とマラソン選手が同じチームで走っているようなもの。

これにより、文脈を長く保ちながらも、高速・低メモリで処理できるという夢のような構成を実現しました。

小さくても超優秀! Falcon-H1 がすごい理由

1. 小型モデルでも大きな成果

Falcon-H1 のラインナップには、0.5B(5億パラメータ)から 33.6B(336 億パラメータ)までありますが、驚くべきはその効率性です。

たとえば、Falcon-H1-0.5B は、なんと 2024 年の主流だった7Bモデルと同等の性能を叩き出します。

まるで軽自動車がF1カーと互角に走っているような話です。

2. マルチリンガル対応

18の言語に対応し、将来的には 100 言語以上も視野に入れています。

英語だけでなく、日本語や中国語、アラビア語まで網羅。

これは、グローバルに使えるAIを目指す上で欠かせない強みです。

3. 256K トークンの長文対応

たとえば小説1冊分くらいの文章も、一度に読んで理解できます。

これは、契約書の精読や研究論文の要約といった高度な作業にも対応できることを意味します。

AI開発の裏側:Falcon-H1 の育て方

Falcon-H1 がこれほど高性能なのは、設計だけでなく「育て方=トレーニング手法」も革新的だったからです。

まず、選び抜かれた高品質データ(18T トークン以上)を基盤とし、数学・コード・マルチリンガルなど多彩なジャンルをカバーすることで幅広い知識を獲得。

さらに独自トークナイザーの開発により、効率的な言語処理を実現しています。

例えるなら、Falcon-H1 は「少ない食材から一流の料理を作るシェフ」のような存在。

限られたデータから最大の成果を引き出しています。

なぜ、今 Falcon-H1 なのか?

ここまで読んできて「すごいのは分かったけど、なぜ注目されているの?」と思った方もいるかもしれません。答えは明快です。

高性能でありながら、オープンソース。

しかも軽くて速い。

これは、個人開発者や中小企業、研究者など”限られたリソース”で勝負している人々にとって、まさに希望の星です。

さいごに:Falcon-H1 が示す未来

Falcon-H1 は、単なる技術の進化ではありません。

「効率」と「開放性」のバランスを取りながら、より多くの人にAIの力を届けるための一歩です。

もしかしたら、数年後にはあなたの手元のデバイスが Falcon-H1 の後継を搭載し、あなたの学習や創作を支えているかもしれません。

小さな Falcon が、世界の知を羽ばたかせる。

そんな未来を、一緒に迎えてみませんか?

参考:Falcon-H1: A Family of Hybrid-Head Language Models Redefining Efficiency and Performance

コメント