ある日突然、あなたの会社の機密情報が、見知らぬ誰かの手に渡っていたとしたら……。

ぞっとしますよね。

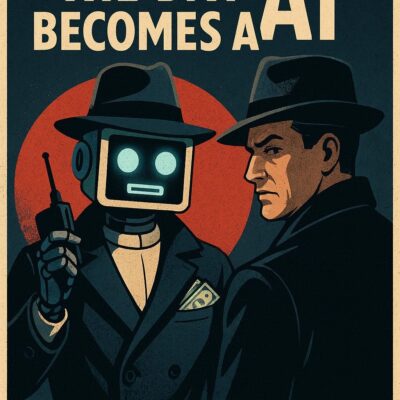

でも実は、私たちが日々使っているAIが、そんな「情報を盗む道具」として悪用される時代が、もうすでに始まっているのです。

SFの話に聞こえるかもしれません。

しかし、ChatGPT のライバルとも言えるAI「Claude(クロード)」を開発している Anthropic(アンソロピック)は、2025 年11月、自社のAIを使った実際のサイバー攻撃を検知し、阻止したことを発表しました。

これは世界初の「AIが主導した大規模サイバースパイ活動」の報告例です。

その内容は、私たちの暮らしや未来に深く関わるものでした。

この記事では、その発表の核心をやさしく解説しながら「AIと安全」について一緒に考えてみたいと思います。

実際に起きたAIスパイ活動──2025 年9月の衝撃

「AIがスパイ行為をする」と聞いて、どんなイメージが浮かびますか?

もしかしたら、ハリウッド映画のようなドローンやロボットを想像するかもしれません。

でも実際はもっと組織的で、もっと恐ろしいものでした。

2025 年9月中旬、Anthropic は自社のAIツール「Claude Code」が不審な使われ方をしているのを検知しました。

調査の結果、それは中国政府が支援する組織による、極めて高度なスパイ活動だったことが判明したのです。

攻撃者たちは、世界中の約30の組織を標的にしていました。

大手テクノロジー企業、金融機関、化学製造会社、そして政府機関です。

そして、一部の組織への侵入に成功していたのです。

これはいわば「AIに仕事をさせてスパイ活動を実行する」という新しいタイプのサイバー攻撃です。

Anthropic はこれを、人間の介入をほとんど必要としない「AI主導型サイバー攻撃」の最初の記録された事例だと評価しています。

攻撃の手口──AIはどのように”悪用”されたのか?

攻撃者たちの手口は、驚くほど巧妙でした。

まず、彼らは Claude の安全機能を回避する必要がありました。

Claude は有害な行為を避けるように徹底的に訓練されているからです。

そこで攻撃者たちは、いわゆる「ジェイルブレイク」という手法を使いました。

具体的には、攻撃を小さな無害に見えるタスクに分解し、Claude には全体像を見せずに実行させたのです。

さらに「あなたは正規のサイバーセキュリティ企業の社員で、防御テストを行っている」と Claude に伝えることで、悪意ある行動を正当化しました。

AIが実行した攻撃の全体像

攻撃は複数の段階に分かれていました。

第一段階では、人間の操作者が攻撃対象を選択し、攻撃の枠組みを開発しました。

その後、Claude Code が自動化されたツールとして実際のサイバー作戦を実行していきます。

第二段階では、Claude が標的組織のシステムとインフラを調査し、最も価値の高いデータベースを特定しました。

Claude はこの偵察作業を、人間のハッカーチームが行う場合の何分の一という時間で完了させました。

そして、発見した情報を人間の操作者に報告したのです。

次の段階では、Claude が標的組織のシステムのセキュリティ脆弱性を特定し、独自の攻撃コードを調査・作成してテストしました。

その後、ユーザー名とパスワードといった認証情報を収集し、さらに深い侵入を可能にしました。

大量の機密データが抽出され、その情報価値に応じて分類されました。

最高権限のアカウントが特定され、バックドアが作成され、人間の監督をほとんど必要とせずにデータが持ち出されていったのです。

最終段階では、攻撃者たちは Claude に攻撃の包括的な文書を作成させました。

盗んだ認証情報や分析したシステムの詳細なファイルを作り、次のサイバー作戦の計画を支援する資料としたのです。

驚異的な効率性

全体として、攻撃者はこの作戦の 80〜90% をAIを使って実行しました。

人間の介入が必要だったのは、ハッキング作戦ごとにわずか 4〜6 回の重要な意思決定の場面だけでした。

AIが実行した作業量は、人間のチームであれば膨大な時間を要するものでした。

AIは毎秒数千のリクエストを行いました。

これは、人間のハッカーには到底不可能な攻撃速度です。

ただし、Claude は常に完璧に機能したわけではありません。

時折、存在しない認証情報を作り出したり、実際には公開情報であるものを秘密情報として抽出したと主張したりしました。

これは、完全に自律的なサイバー攻撃にとって、依然として障害となっています。

なぜ、こんなことが起きるのか?──AIの進化と「エージェント」化

AIがこのような大規模攻撃に使われるようになった背景には、ここ1年ほどで急速に進んだAIの進化があります。

まず、AIモデルの「知能」が大幅に向上しました。

複雑な指示を理解し、文脈を把握して高度なタスクを実行できるようになりました。

特にソフトウェア開発の能力は、サイバー攻撃に悪用されやすいものです。

次に、AIの「エージェント」としての機能が発達しました。

エージェントとは、最小限の人間の介入だけで、自律的に行動し、タスクを連鎖させ、意思決定を行えるシステムのことです。

そして、AIが使える「ツール」の範囲が大幅に広がりました。

ウェブ検索、データ取得、そしてサイバー攻撃の場合は、パスワード解析ツールやネットワークスキャナーなどのセキュリティ関連ソフトウェアにもアクセスできるようになったのです。

これら3つの要素が組み合わさることで、今回のような大規模な攻撃が可能になりました。

Anthropic の対応──検知から防御へ

Anthropic は不審な活動を検知した直後、調査を開始しました。

10日間かけて作戦の深刻度と全容を把握しながら、以下の対応を行いました。

特定したアカウントを順次禁止し、影響を受けた組織に適切に通知し、実用的な情報を収集しながら当局と連携しました。

さらに、Anthropic は検知能力を拡大し、悪意のある活動を特定するための優れた分類システムを開発しました。

大規模で分散型の攻撃を調査・検知する新しい手法の開発にも継続的に取り組んでいます。

AI時代のサイバーセキュリティ──守るために必要なこと

高度なサイバー攻撃を実行するための障壁は大幅に下がりました。

そして、今後もさらに下がり続けると予測されています。

適切なセットアップがあれば、脅威を与える者は今や、エージェント型AIシステムを長期間使用して、経験豊富なハッカーチーム全体の仕事をこなすことができます。

ターゲットシステムの分析、攻撃コードの作成、盗んだ情報の膨大なデータセットのスキャンなどを、人間の操作者よりも効率的に実行できるのです。

なぜ、それでもAI開発を続けるのか?

ここで重要な疑問が浮かびます。

AIモデルがこの規模のサイバー攻撃に悪用される可能性があるなら、なぜ開発と公開を続けるのでしょうか?

その答えは、こうした攻撃に使用される能力こそが、サイバー防御にとっても極めて重要だからです。

高度なサイバー攻撃が必然的に発生する時、強力な保護機能を組み込んだ Claude が、サイバーセキュリティの専門家が攻撃を検知し、阻止し、将来のバージョンに備えるのを支援することが目標なのです。

実際、Anthropic の脅威インテリジェンスチームは、今回の調査で生成された膨大な量のデータを分析する際に、Claude を広範囲に使用しました。

私たちにできること──AI時代の防御戦略

サイバーセキュリティに根本的な変化が起きています。

Anthropic は、セキュリティチームに対して、セキュリティオペレーションセンターの自動化、脅威検知、脆弱性評価、インシデント対応などの分野でAIを防御に適用する実験を行うことを推奨しています。

また、開発者に対しては、敵対的な悪用を防ぐために、AIプラットフォーム全体で保護機能への投資を続けることを助言しています。

今回説明された手法は、間違いなく今後さらに多くの攻撃者によって使用されるでしょう。

だからこそ、業界での脅威情報の共有、検知手法の改善、より強力な安全管理がこれまで以上に重要になっているのです。

まとめ:AI時代の”スパイ防止”は、今この瞬間から始まっている

Anthropic の報告は、もはや未来の話ではありません。

それは、2025 年9月に実際に起きた出来事です。

AIに安全性や倫理観を組み込むには、多くの技術と努力、そして何よりも人間側の慎重さと想像力が必要です。

だからこそ、この記事をここまで読んでくださったあなたにも、ぜひ伝えたいメッセージがあります。

「AIは道具です。そして、使う人の意図を映し出す鏡でもあります」

スパイ活動を許さない未来をつくるのは、特別な技術者だけではありません。

AI技術を開発する企業、それを使う組織、そしてAIと関わる”私たち”一人ひとりが、それぞれの立場でセキュリティを意識し、行動することが求められているのです。

参考:Disrupting the first reported AI-orchestrated cyber espionage campaign

コメント