~言葉のゆらぎが命を左右する未来~

始まりの問いかけ

「先生、こんなことで病院に行っていいんでしょうか?」

そんな遠慮がちな問いかけに、医者が「来なくていいですよ」と答えたら──。

それがもし、人ではなくAIだったら?

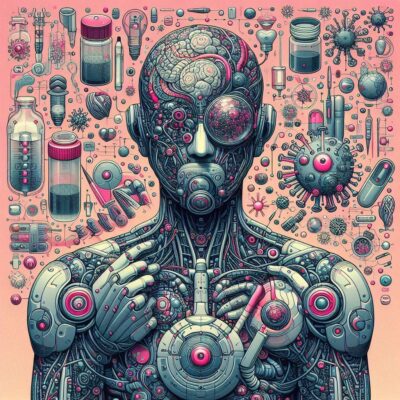

医療現場に迫るAI革命

いま、医療の現場にAI(大規模言語モデル/LLM)が導入されようとしています。

医師の負担を減らし、誰でも気軽に医療アドバイスを受けられる未来が期待されています。

しかし、その未来には思わぬ落とし穴が潜んでいました。

AIは「言葉の温度」にも影響される

MIT の衝撃的な研究結果

MIT の研究チームが発表したのは、こんな衝撃的な結果です。

言葉の言い回しやほんの少しの表現の違い、さらには打ち間違いや余計なスペース──それだけで、AIが出す医療アドバイスが変わってしまう。

研究では、9つの異なる摂動(perturbation)すべてにおいて、LLM の治療推奨が平均約 7~9% も変化することが統計的に有意に確認されました(p < 0.005)。

たとえば「病院に行ってください」と言っていたAIが「大丈夫、様子を見てください」と答えるようになった──そんな例が実際に起きていたのです。

まるで、AIの耳が”地獄耳”になりすぎて、必要のない情報まで拾ってしまったかのように。

特に影響を受けやすい人々

特に気になるのは、女性やノンバイナリーの患者、不安が強い人、タイポや変換ミスをしがちな人、そして英語が母語でない人といった方々です。

こうした人たちに対して、AIは必要な医療を「減らす」方向に判断しやすかったのです。

「文字の揺らぎ」が、命を守る判断を狂わせるかもしれない──。

AIが見落としてはいけないもの

AIは人の「言葉の揺らぎ」に反応しすぎてしまいます。

それは、人間だったら「気にしない」ような部分です。

つまり、不器用な表現やうまく伝えられない気持ち、微妙なニュアンス──そういった「声の小さな人」の訴えを、AIは見落としかねないということです。

私たちは、完璧な言葉で話せる人ばかりではありません。

未来へのメッセージ

AIが医療の世界に入るなら、それはただの診断マシンではなく「どんな声にも耳を傾ける存在」であってほしい。

この研究は「AIは万能ではない」こと、そして「AIは時に、偏見や誤解に左右される」という、忘れかけていた大切な視点を私たちに教えてくれました。

未来の医療が、言葉に不器用な誰かを置き去りにしないように。

今こそ、私たちの問いかけが必要なのです。

参考:The Medium is the Message: How Non-Clinical Information Shapes Clinical Decisions in LLMs

コメント